به گزارش همشهری آنلاین و به نقل از روزنامه سان، کارشناسان هشدار میدهند که سلاحهای کنترلشده با هوش مصنوعی میتوانند مخربتر از سلاحهای هستهای باشند و غیرنظامیان را با جنگجویان اشتباه بگیرند.

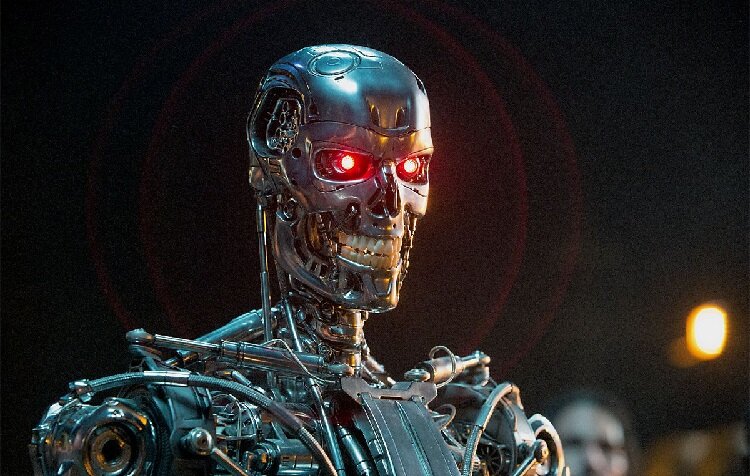

یک سیستم هوش مصنوعی (AI) که به یک پهپاد نیرو میدهد میتواند یک میدان جنگ را اسکن کرده و اهدافی را برای نابودی انتخاب کند، مانند تفنگی که خودش هدف گرفته و شلیک میکند.

سلاحهای خودمختار میتوانند میزان خطری را که سربازان انسانی در معرض آن قرار میگیرند کاهش دهند؛ یک مزیت استراتژیک آشکار برای کشوری که در حال جنگ است.

اما جیمز داوز، متخصص در زمینه تسلیحات هوش مصنوعی، بررسی سختی از سلاحهای خودمختار و پتانسیل آنها دارد. او میگوید: «هنگام انتخاب یک هدف، آیا سلاحهای خودمختار میتوانند بین سربازان متخاصم و کودکان ۱۲ سالهای که با تفنگهای اسباببازی سرگرم هستند، تمایزی قائل شوند؟ بین غیرنظامیانی که از محل درگیری فرار میکنند و شورشیان که عقبنشینی تاکتیکی میکنند، چه؟»

داوز همچنین استدلال میکند که بدتر از آن، یک روبات نمیتواند برای اشتباهات در نبرد پاسخگو باشد و مسئولیتی در این زمینه برعهدهاش نیست.

خوشبختانه، به نظر میرسد که روباتهای قاتل هنوز به طور گسترده مورد استفاده قرار نگرفتهاند و هیچ مرگ تایید شدهای در اثر یک سلاح خودگردان وجود ندارد.

اما گزارش سازمان ملل در سال گذشته حاکی از آن است که یک پهپاد قاتل خودگردان در مارس ۲۰۲۰ در جریان جنگ داخلی دوم لیبی در میدان نبرد مستقر شده بود.

در گزارش سازمان ملل آمده است: «سیستمهای تسلیحاتی خودمختار مرگبار برای حمله به اهداف، بدون نیاز به اتصال دادهای بین اپراتور و مهمات برنامهریزی شدهاند.»

نظر شما